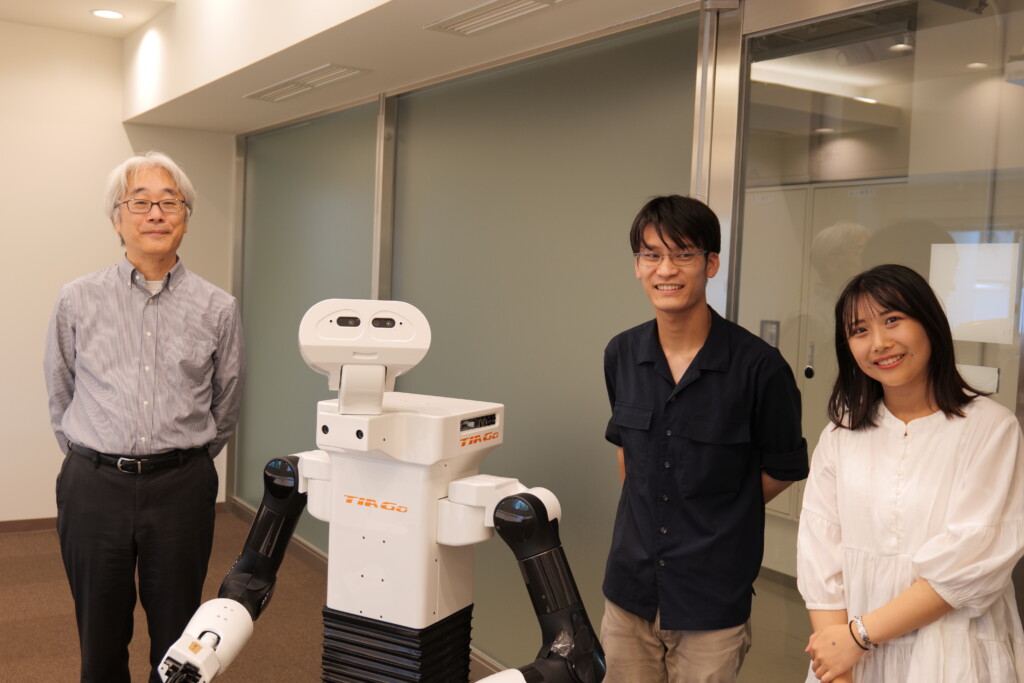

研究者/神田 崇行 | ロボットのいる建築空間 ―人・ロボット共存への過渡期に交流を考える―

Takayuki KANDA | Architectural Spaces with Robots: Rethinking Interaction Toward Human-Robot Symbiosis

聞き手・構成:森 翔一、聞き手:大野 ひかり、村上 凌

取材日:2025年7月7日

AI(人工知能)技術の進化は、私たちの社会を根底から変えつつある。しかし、その情報技術が、私たちが暮らす「現実の空間」にどのような影響を与えるか、具体的に思い浮かべることはできるだろうか。そこで本号では、「リアルの場所を占めるAI」とも言えるロボット技術に着目する。特に、人とロボットの関わりを研究する「ヒューマン・ロボット・インタラクション(HRI)」分野の第一人者である、京都大学大学院情報学研究科の神田崇行先生にお話を伺った。ロボットが活躍する建築、都市空間の行方を探る。

きっかけ

――神田先生がロボット研究に惹かれたきっかけは何でしょうか。

神田 多くの⼈がそうだと思いますが、漠然とロボットが⼩さい頃から好きでした。研究の題材としてやろうと思ったのは、結果論かな。大学で情報学科に⼊ったわけですよ。私が入学した当時は、まだコースに分かれておらず、のちの計算機科学コースなどもすべて「情報工学科」という一つの学科でした。情報学科では3回生で実習があり、その中でたまたま、ロボットを動き回らせるテーマがありました。当時情報学科の⼈⼯知能の研究室の教授をされていたのが(アンドロイド研究で著名な)⽯黒先⽣で、ロボットの実習をやっていたんですね。ロボットを環境の中で⾃分の位置を調べながら動き回らせるプログラミングです。その演習が⾯⽩かったんですね。ロボットもうまく動かすことができて。研究室を4回生で決めるわけですよ。その時に⼈⼯知能の研究室に⾏こうと思いました。そこからなんとなく研究をやり始めたら⾯⽩くなってきました。

――先生が学生の頃は、まだ情報学の分野が細分化されていなかったのですね。「ヒューマン・ロボット・インタラクション(HRI)」という分野は、いつ頃「人工知能」から独立して確立されたのでしょうか。

神田 まず私が博⼠で研究を始めたのが2000年ぐらいです。ホンダがASIMO(アシモ)という二足歩行ロボットを発表したり、SONYからAIBO(アイボ)という犬型ロボットが登場したりと、ちょうどそういう時期です。人とロボットがインタラクション(相互作用)する研究が始まった時期ですね。それまでも発想はあったと思うんです。というのも⼆⾜で歩くロボットなんかを⾒ていると、できそうな気がしませんか。でもどうやって作っていいかわからなかった。私が研究を始めたのはそれぐらいの頃なんですね。国際会議が始まったのは2006年ぐらいです。先に研究を始めている方が、(分野を先導できるので)有利ですよね。幸いなことに私は先に(ロボットの)研究をしていました。例えば私の博士研究は⼩学校で英語をしゃべるロボットの研究なんです。その後にアメリカの研究者たちが、「ロボットは何に使えるだろうか。そうだ、語学学習だ」と考え始めたのです。私が先に行った研究を、後から他の方が追随するような流れが起きました。結果的には研究分野の中では影響⼒があるということになっています。2018年にこの研究室ができて、ヒューマン・ロボット・インタラクション研究をここでやっていますけれども、その国際会議が始まったのは2006年。分野の萌芽は、それよりもう少し前から徐々に始まっていたのでしょうね。

他分野の方との関わり

――研究のお話を聞くと、情報学だけにとどまらないように感じました。他分野との接点にはどのようなものがありますか。

神田 ⼼理学の先⽣、認知科学の先⽣とはいろんなところで議論して、時にはコラボして、時には勉強して、国際的に研究しています。お互いに⾯⽩いところがあって、⼈と仲良くコミュニケーションできるロボットを作ろうと思うと、⼈間の⼼理、認知心理の研究から学ぶところもいっぱいあるんです。しかし⼼理学の先⽣からすると、人間を対象にした実験では、被験者を自由自在にコントロールすることはできませんよね。例えば、視線を動かさないでコミュニケーションしてくださいというのは人間には無理でしょ。それがロボットならできるわけですよ。コミュニケーションするときに視線が動かない。そうすると、ロボットを使った実験によって「視線にはこんな機能があったのか」とわかることがあるわけです。作ってみることで、それがどういう⾵にできているのかな、どう役⽴つのかな、って調べていくこともできるわけです。だから、情報学的なコミュニケーションをするロボットを作ることと、人間やエージェント(自律的に動作するソフトウェアなど)とのやり取りを調べること、この2つの分野は親和性が高く、密接に連携して研究できるのです。

――ツールとしてロボットを作ることで、認知科学の分野に、新しい研究手法を提供できることもあるのでしょうか。

神田 そうですね。⼈の形をしたロボットそのものもツールですし、ロボットが引き起こすいろんな現象も⾯⽩い研究の題材ですよね。僕らが研究する中で、ロボットを⼦供たちがいじめるみたいな現象があって。⼈間のいじめとかは研究できるわけないじゃないですか。子供は楽しいのだけれど、少しやりすぎてしまうこともある。ロボットが「嫌だ」と反応しているのに、子供が「もうちょっと」といじめてしまう現象だとしても、遊びの範囲なので観察して、どうやったら状況変わるのかという実験ができる。

最近の傾向

――ここまで技術が進むとロボットがまるで⼈間みたいだと思うところもあります。一方で⼈間とは違う点や、再現できてない点はどこにあるのでしょうか。

神田 僕らが最近注⽬して研究しているのはモラルです。あるいはモラル・インタラクションですね。ロボットが目の前に手を差し出せば、多くの人は反射的に握手をしてしまうと思うんです。ロボットが社会的に振る舞うことは結構うまくできるようになってきていると思います。でも僕らがモラル・インタラクションの研究を始める頃によく題材にしていたのは「⼈の⽬があったら悪いことできないじゃないですか」ということ。「ロボットが監視していると、私たちの行動は本当に変わるのか?」ということです。例えばアメリカのスーパーでは、挨拶係(グリーター)に人が雇われています。ちょっと⼤きいスーパーの⼊り⼝で、「こんにちは」と言うだけのお仕事。それだけ聞いたらロボットにできそうだと思いませんか。⼈の距離を測って、お辞儀します。技術的には簡単です。でも多分ロボットは雇ってもらえないと思います。というのも⼈間の挨拶係は、そこにいると万引きが減るんですね。⼈の⽬ですよね。にこやかな⼈が⽴っているだけで、やっぱりできない気がするわけです。この「人の目」の効果ばかりは、ロボットには代用できないですよね。「相手がいるからお互いに規範を守らなければ」と考える、この本質的な「モラル」の対象に、まだロボットはなっていないと思われます。さっきのいじめなんかもそうです。ロボットであれば、蹴ったり叩いたりして相手が「嫌だ」と言ってもやめなくていい、と思ってしまうのは、ロボットはモラルの対象だと思えないから。⼈間っぽく⾒えるけど、⼈間とはまだすごい本質的なところで違うところもあって。そのギャップを埋め切れるのかどうかは分からないですし、埋めちゃったらロボットにお給料を払わなきゃみたいな話になるから、それは嫌ですけどね。だからこそ、その中間をどう設計するかが大事なのかもしれません。モラルの対象として一切認識されなければ、将来ロボットが店員として働くことも難しいですよね。ロボットとのこのモラル的なギャップをどう埋めるかというのは、興味の対象だと思います。

――やはり⼈間か非⼈間かという本質的な点に、大きな隔たりがあるのですね。

神田 (その隔たりを)埋めてしまっていいかわからないわけですよ。技術的に可能だとしてもね。火事になったら、人間よりも先にロボットを抱えて逃げるような社会では、本末転倒ですよね。でも、ロボットが⾒ていたら悪い⾏いをしないぐらいの将来は作りたいかもしれない。この「程よい加減」をどう設計していくのかが、面白い研究テーマですね。例えば道案内の研究とかをして、ユーザーの⼈たちに聞いてみるんです。ロボットと人間のどっちに案内してほしいですかと。2/3くらいの人がロボットと答える。なぜかって聞くと、ロボットだと迷惑じゃないでしょと。⼈間だったらやっぱり気にしちゃうわけですよ。ロボットの⽅が公平だっていう⼈もいますし、珍しいからだっていう⼈もいます。様々ですけれども、そこにはロボットならではの価値がありそうです。

――先ほどアシモが2000年ごろに登場したというお話がありました。現在インタラクションするようなロボットとして身の回りにどういったものがあるのでしょうか。

神田 少し前に、⼀番⾝近になりそうになって、消えちゃったのは、Pepper(ペッパー)かなと思いますね。ペッパー君、コンセプトは⾯⽩いなとは思って、非常に安価に提供しようと努力した点は素晴らしいのですが…でも何度もそういう動きが起きていますよね。少し前だとAmazonが家庭用にAstro(アストロ)というロボットを発表しました。スマートスピーカーのAlexa(アレクサ)に車輪がついて動き回るようなものです。それもあり得たかもしれないけれど、やっぱり15万ぐらいするとみんな買わない。でも何度もそういう動きが起きながら、ありそうな製品に近づいてきている気がするんですね。最近、LLM(ラージ・ランゲージ・モデル:大規模言語モデル、いわゆる生成AIの中核技術) が世に出始めて、今までロボットが超えられなかった壁を超えられる可能性も出てきてるんじゃないかなと思いますね。人工知能やロボットにとって非常に難しかったのが、シンボルグラウンディング(記号接地、言葉と実物を結びつけること)の問題です。物の意味が分からないんです。これがペンですっていうのは分かっても、それを持てる、それで書ける、場合によってはそれを投げられる、といったものの意味がわからない。すごく難しかった。従来のAIが苦手としていたのは、こうした実世界と結びついたパターンに基づく思考なんです。「ペン」という記号(シンボル)を作り、「ペンを使えば書ける」という知識をルールとしてプログラミングしていくことはできても、現実世界の多様性にすぐ対応できなくなり、あっという間に現実とのギャップが生じて破綻してしまうんです。でも⼤量のデータが集まってきた時に、この問題が解けるんじゃないかなというのが、突破⼝かもしれないと思いますね。、今までできていなかったけど、ロボットが徐々に活躍する⽇は、案外近くにあるのかもしれないなと思いますね。

――⼤量のデータが集まると、そのデータの中に類するものが⾒つかり、シンボルを認識できるようになるという流れでしょうか。

神田 単純なシンボルグラウンディング(言葉と実物を結びつけること)という意味で言えば、深層学習(ディープラーニング)と大規模データによって、ものを識別できるようになったのが、ひと昔前のすごい進歩でした。世の中はパターンでできているわけですよね。例えば知らない⼈の家に⾏って、そこでコーヒーを作れますか。難しいですよね。でも人間はできるわけですよ。コーヒーメーカーを見て、コーヒーの粉がここにあって、フィルターがあってと(判別して作ることができる)。⼀個⼀個のものが全部形が違うし、場合によっては作り⽅が違うし、⽔道がどこにあるかもわからないし。しかし、自然言語(人間の言葉)で記述すれば、「水道から水を汲んで、お湯にして…」と手順を書くことができますよね。このパターン(実世界)とシンボル(言語)が結びつくと、問題が解けるようになるわけです。でもこれをプログラミングするとなると、難しかったわけです。今は、随分できるようになりました。

――先ほどの例で⾔うと、パターンが⾃然⾔語の「⽔に⼊れる」という話で、シンボルが具体的に「ここの蛇⼝をひねってどう出すか」という流れですか。

神田 そうですね、いわゆる⽇常の知識は、全部つながりで書けるわけですね。蛇⼝も⼀個⼀個形は違うし、ものや作業の流れ⽅だって⼀個⼀個違う。でも人間は要約して⾔葉で書けるわけですね。人間の日常知識は、いわばパターンの塊なわけです。そのパターンの塊をAIがようやく扱えるようになってきたのが、情報学の⼀つの最先端で、皆さんもChatGPTとか楽しく使ったり、時には頼ったりしていると思うんですけど、そこで解けてるのは⾃然⾔語の⾔葉のつながりの問題ですよね。

ロボットの空間事情

――ロボットの実験は、建物内で⾏っているものが多いですよね。パターンやシンボルなどのロボットの現実認識(シンボルグラウンディング)のお話がありましたが、ロボットが活動する上で活動しやすい建物と、活動しにくい建物はあるのでしょうか。

神田 ロボットで⼗数年前に⾰新的に伸びたのが移動です。距離を測れるようになりました。建築の分野でも部材の計測などにレーザーが使われるかと思いますが、ロボットでも回転しながら全方位の距離を測るようなセンサーが使われるようになってきて、ほかには⾃動運転の⾞にも使われています。ロボットが「自分は今どこにいるか」を把握する技術が、非常に発展しています。位置が正確に分かって初めて、自由自在に目的地へ移動できるわけです。これはロボットの能⼒がどんどん増えた瞬間です。だからそれをやるために地図を作らなきゃいけないんです。それを作るために、ロボットにちょっとずつ動きながら距離を測ってもらうわけですね。ありとあらゆる場所の距離を測ると、環境の立体地図ができるわけです。それが(ロボットを動かすための)基本情報です。この情報が取りやすいところと取りにくいところが当然あります。ものとの距離がしっかりしているところが⼀番やりやすいわけです。静的で、センサーが届く範囲に壁や物がある環境。最高ですね。反対に、人や物が動き回り、開けていて距離が遠い場所は、非常に困難です。広いところは⼤変なんです。

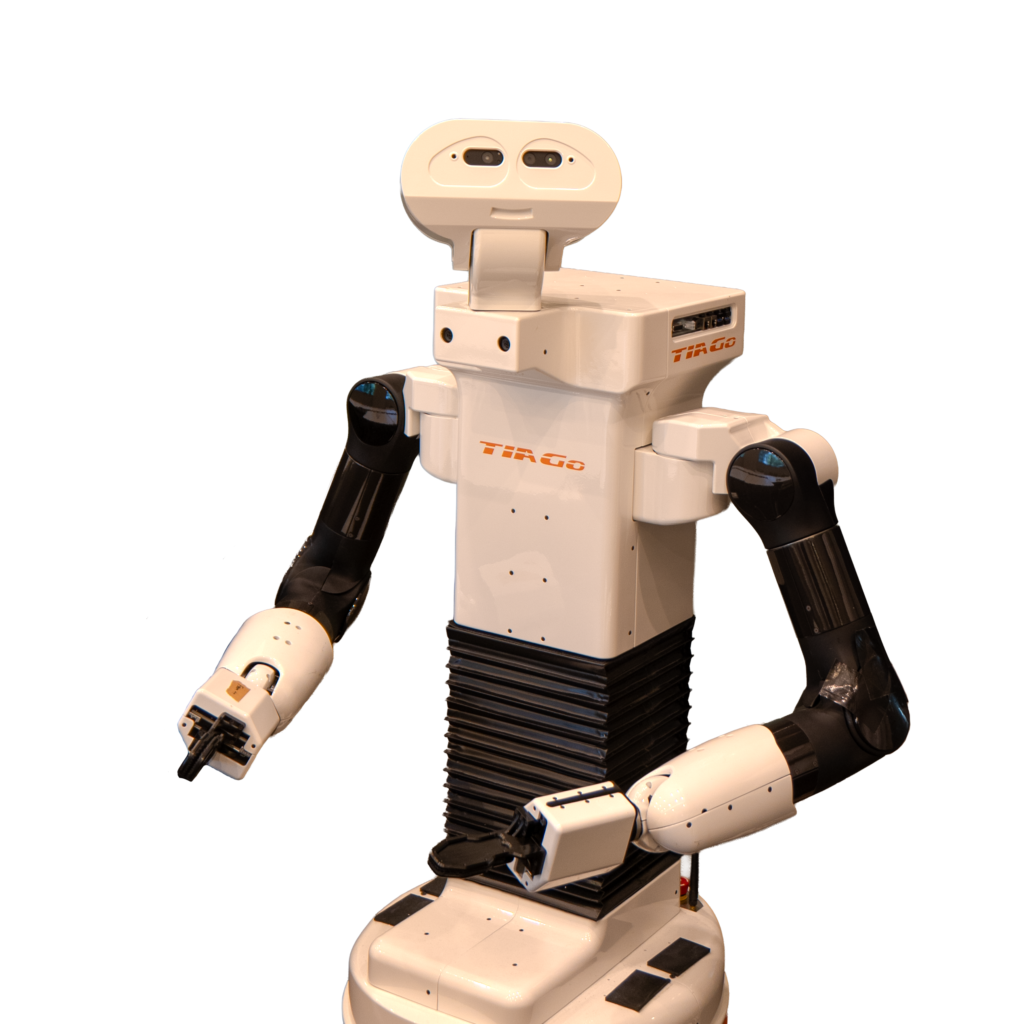

上手な人と同程度の73.3%の成功率でチラシを受け取ってもらうことに成功した[1]

――なるほど。そうすると建物内より、都市空間のほうがロボットを動かすのは難しいのですか。

神田 まあ広いとしんどいですね。自動運転車の場合、「車道上を走る」という強い制約があるのでまだ対応しやすいのですが、広場や歩行者空間のような自由空間で、広くて、しかも周りの人が不規則に動き回る環境は、さらに困難です。

――広さのお話がありましたが、建物の形状によって難しさは変わるのでしょうか。

神田 多少のカーブはあんまり関係なくて、距離が測れますから。むしろ完全にまっすぐな⽅が特徴がなくてよくないかもしれない。現実のロボット運用で困るのは、ガラス張りです。距離を測りますから、反射しちゃったりとか、反対側が見えちゃったりとか。でもそれも仕組みによるので、(一概には言えません。)例えば天井を認識して動くロボットもあります。天井カメラで動くんじゃなかったかな。(いろんな方法がある中から)その環境でうまく機能し、コストに見合う技術を選択して使うわけです。

ロボットからみた建築

――コスト面以外で、ロボットの社会実装のネックになるのはどのような点ですか。

神田 もちろん技術的にも難しいところもあって、ペッパー君のロボットなんかも、⼈がいるとロボットの移動は難しくなります。誰もいなかったら別に決まったルート上をまっすぐ行ったらいいんです。けれども人がいたらいけないですよね。その人の動き⽅も不規則ですよね。⼈がいる中でロボットが計算すると、時々動かない⽅が正解の結果になってしまうんです。動いたらぶつかっちゃうかもしれない。だから動けなくなっちゃう。そうなると、傍目にはロボットの性能が低く見え、結果として「動かない」ロボットになってしまう。技術的には⼈みたいにできないところがありますよね。移動自体もそうですし、まして⼈間が出てくる環境で、ロボットが一体何したいと思って、どうすれば人の邪魔にならず、どうすれば人の役に立てるのか、というのは、まだまだ手探りなのが現状です。

――今現在実践、実験問わず実際に使われている、ロボットとしての役割はどのようなものが多いのでしょうか。

神田 お掃除、それから、運搬、宣伝、案内といった用途は、街中では⽐較的多いんじゃないですかね。ちょっと珍しいかなというところでは、案内したり、客引きしたりしている場合もあると思います。私が案内ロボットを非常に面白いと思っているのは、それがロボットの社会進出の「入口」として、コストをかけてでも、まずは単純な形で人の役に立ち始める点にあります。最初は、街中でそうした非常に単機能なロボットから始めても良いと思うんです。それこそ挨拶係なんかすごい単純じゃないですか。「こんにちは」、「いらっしゃい」ってやってるだけで。公共空間だとそれでもお給料をもらえるわけです。家庭用で、玄関で「お帰りなさい」と言うだけのロボットには、誰もお金を払わない。最初に公共空間でそうした機能が受け入れられ、そこからどんどん機能が増えていくと、最終的には世の中でいろんなことができるロボットが⼊っていくんじゃないかなと思います。案内で終わるとは思いませんけれども、ロボットの「仕事始め」としては、非常に面白いことではないかと思います。

――案内と聞くと掃除や運搬よりも、人間にロボットの側から能動的に話しかける必要があるように感じますね。ロボットから能動的に話しかけにいくほうが、受動的にインプットを受けてアウトプットを返すよりも、難しいのでしょうか。

神田 はい、圧倒的に難しいです。なぜなら、待機しているだけなら誰も文句を言いませんよね。(ロボットの話を)聞きたい⼈だけが話しかけているわけで。(ロボットが人に)近づいて(話しかけに)いこうと思うと、僕らもずいぶん研究してるんですけども、研究の最初の頃は散々な結果でした。寄っていったら、無視されたりとかね。人間が、すれ違う人すべてに「こんにちは」と話しかけたらおかしいですよね。邪魔だなって思う⼈もいますし、そもそもロボットは遅いですから、人に追いつくのだって難しいですね。出会うことさえ難しいです。この⼈に⾏こうと思っても、ロボットが遅くて、「ああ、行ってしまった」となる。動きを予測する計算という意味でも、誰をターゲットにすべきかという意味でも、そして「そもそも話しかけることが許容されるのか」という点でも、難しいと感じます。でもインタラクションの始まりってそういうところにあるわけですから。そういう意味ではとても面白い、大事なものなんじゃないかなと思います。

――⼈間とロボットがもっと共存していく社会になっていくと思いますか。

神田 もちろんそうですね。僕らが研究しているのも当然あるんですが、歴史的に見ても、社会は単純作業を機械に任せ、より高度でクリエイティブな仕事を人間が担うよう役割分担を進めてきたと思うんです。そういう意味で、さっきのお掃除、配達、宣伝、案内、何でもそうですけれども、それらは⽐較的単純で、機械が⼊った⽅が安全かつスムーズに運用できそうな仕事だと思うんですね。もしロボットの能⼒さえ伴えば、そういうところには、自然と導入されていくと思うんですよ。⼈間はもっと賢いことをやればいいわけですから。もちろん過渡期には難しいこともあってね、その過渡期の瞬間はどうするんだというのは、いろいろ社会的に議論があるとは思いますけれども、歴史的にはずっとそうですよね。ずっとやっている仕事は変わっていってもいいかと思いますから。(ロボットは)⼊ってくると思いますけどね。

――ロボットが導入されると、建物側にも、例えば段差をなくすといった変化が起きてくるのでしょうか。

神田 そうした変化も良いと思いますが、そもそも世の中は「バリアフリー」化を進めていますよね。⾞椅⼦が動き回れるように、⾃然ともう(建築側が)作っているわけじゃないですか。ロボットの多くは、車いすのサイズ(幅)の内側に収まるように設計されていますから。⾞椅⼦が動けるところだったら⾏けるはずなわけです。ロボットのためよりも先に⼈間のために。⼈間の様々な⾏動能⼒のために人間中心のバリアフリー化によって環境が変わり、結果としてロボットも活動しやすくなって導入が進む、という相乗効果は起きやすいと思います。

――技術が進んで、ロボットが当たり前の世界になる。ロボットの普及によって、今度は建築側が積極的に影響を受けるようになると面白いですね。

神田 ⾯⽩いですよね。実際、建築の分野でそうした動きは少しずつ起き始めているのでしょうか。少なくともバリアフリーになったことで建築は変わった部分はあるんじゃないかな。

――バリアフリーの観点でいうとスロープをつける必要があるとかはあります。住宅の玄関の「上がり框(かまち)」の段差が低くなってきている、といった傾向もあると思います。

神田 公共空間は総じてバリアフリー化が進んでいる印象なので、住宅は⼀回り時間がかかるのかもしれませんけど、ロボットがそこに入る頃には、そうなっているかもしれませんね。

――技術の社会実装がどこから始まるかという点で、やはり家庭内よりも、公共性があり「人の目」がある空間の方が、ロボットに対するモラル的な課題も議論・解決しやすいのでしょうか。

神田 公共空間では単機能でも役に立てるため、そうした方向での導入が進む可能性はあると私は思いますが、なかなかわからないですからね。(Amazon Echoなどの)スマートスピーカーは家の中から普及しましたからね。

――先ほどガラス張りや階段がロボットにとって難しいという話がありました。ロボットの視点から⾒て、建築をもっとこうしてほしいということはありますか。

神田 そうですね、階段は大きな課題です。移動能力という点では、車いす以上に斜面も苦手です。あるいは、建築を変えてほしいという意味ではありませんが、ロボットは点字ブロックの凹凸にも引っかかってしまいますから。なかなか移動能⼒という面では難しいところですよね。

――ドアなどの、ノブを引いて押すといった動作も難しいですよね。

神田 それだけで研究になります。⼀番よくできたデモでは動いているとは思いますけれども、日常的にやっているロボットはなかなかないんと思いますね。

――とするとやはりロボットの動く環境としてはドアはないほうがいいですか。

神田 ボタン一つで勝手に開くようなものは使えます。実際にはドア側で対応している例があって、アメリカの病院でベンチャー企業がやってるのは、⾞椅⼦の⼈のためにボタンを押すと自動で開閉するようなドアがついてたりするんですよね。そういうボタンがついてると、ロボットがそのボタンさえ押せれば(あるいは操作できれば)通過できるので、ロボットにとっては格段に楽になります。そういう意味では結局バリアフリーと似たような話ですよね。車いすの方にとっても、ドアの開閉は大変ですから。

――ある人にとってのバリアフリーである点字ブロックや手すりがロボットにとっての障害物になる側面もあるのではないでしょうか。

神田 点字ブロックは頑張ったら乗り越えられる。ロボットにぎりぎりの移動能力を与えているから、超えられないだけ。点字ブロックよりもロボットの方を変えるべきかなと思います。階段となると話は全く別で、現在の一般的な車輪機構では階段を登ることは困難です。そういう意味では階段を通らずに、動き回れる⽅がロボットにとっては断然動きやすいでしょう。⾞椅⼦でも同じですよね。ベビーカーを連れていても同じで、私にも小さい子どもがいますが、ベビーカーを押していると途端に街を動きにくくなります。ロボットと同じ困難に直面しているなと感じます。

建築とロボットの接点

――ロボットがいると、珍しさから人が集まってしまい動線の妨げになるため、あえてロボットを少し動かすといった工夫もあると聞きます。そのように、ロボットが空間に影響を与える事例はほかにもあるのでしょうか。

神田 やはり混雑というのが一番に思いつく例です。この問題には、ロボットがどこにいるとどういう混雑が起きるかなというシミュレーションをしてみると、ロボットにとって最適な場所を見つけることができたんです。建築の分野でもシミュレーションは使われるのですか。

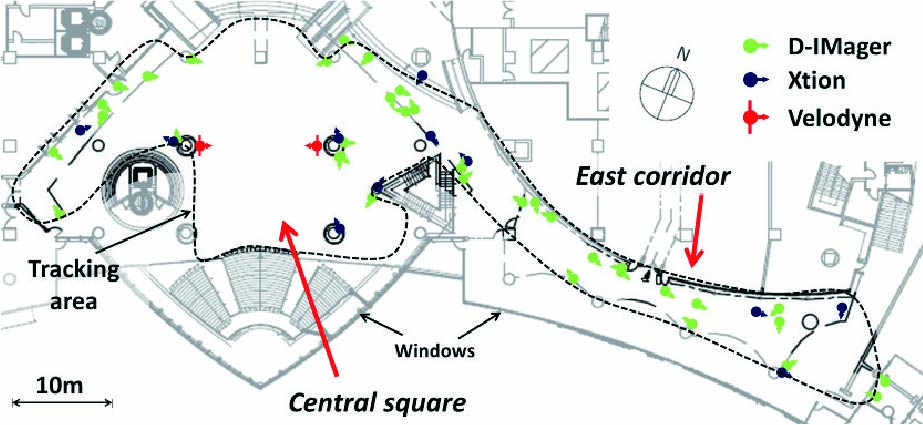

――はい、人流分析などで使われています。先生が街頭空間の実験でされていたような、人がどう動くかのシミュレーションなどですね。

神田 あのプロジェクトをやったときに、まさにそういう歩⾏者モデリングの研究者たちと⼀緒にコラボしてたんです。彼ら曰く、「東京オリンピックの会場計画でも、この歩行者シミュレーションを使いましたよ」といった話は(業界では)よく聞く話です。建築の皆さんもどこかで⽬にされているのかな、と。我々はそれをもとにロボットがいたら歩⾏者はどう行動を変えるのかなっていうのをさらにモデルにしています。

――やはり建築の分野でも駅での滞留の仕方などのシミュレーションがよく出てきます。情報学の技術をさらに建築の⽅にも転⽤できるのではないかと思います。

神田 非常に接点がありそうですね。僕らはシミュレーションするときにまさに⼈流を測っていますから。この環境で平⽇の昼間だったら、これぐらい⼈が⼊ってくるなというデータを持っていますので、データに基づいてシミュレーションしていたんですね。建築はもしかしたら建てる前に、「最大でこれぐらいの人数が来るだろう」というもしもの想定に基づくシミュレーションをする場合も多いのかなと思いますが、情報学の一番の強みは、実際に「測れる」ことかもしれませんね。実際に計測してみたら、シミュレーション結果はさらにこう改善されますよ、と。もしかしたら、似たような別の場所で計測したデータが、新しい場所の計画にも役立ったりするのかな、と。

――最後にはなりますが、ロボットを研究されている立場から、建築に対して望むことや、可能性を感じることはありますか。

神田 建築分野で現在どのような研究が盛んに行われているか、私は詳しく存じ上げませんが、ロボットからすると、周りの環境を理解するというのはとっても重要で難しいタスクです。建築分野の皆さんが、建築環境やその中での人々の振る舞い、環境の状態を把握しようとすることと、(ロボットが環境を理解することは)どこか近いものはないかと思ったりもします。建築分野で、建物を「スマート化」する、つまり、より賢く、アダプティブ(適応的)に、動的にするといった研究は行われているのでしょうか。

――ビルの中で⼈がいないところは自動で消灯しておくという事例はよくありますね。私たちの研究分野(建築計画など)で言いますと、都市の中で自然発生的に作られた環境の成立過程や、その環境がどのような空間特性を持つのかを調査する、といった研究が多いと思います。

神田 ロボットは環境を理解しないといけないんですよ。だから、ちょっとだけ私もやってたんですけど、⼈の流れ、⾏動の情報を取っていくと、場所の意味がわかってきますよね。「この辺りは急ぎ足で通り抜ける場所だな」とか、「ここは立ち止まる人が多い、お店の前だな」とか。単純なことしかわかりませんけれども、場所の意味が分かっているとロボットも行動を変えることができますので。さっきの例で⾔えば、ここはみんな⽴ち⽌まるところなんだ、じゃあロボットは邪魔しちゃいけないとか、邪魔してもいいとか、ここなら待ってていいとか、ここは場所を取らない⽅がいいとか、⾏動を変えられるはずです。例えばエスカレーターを上がってすぐのところにロボットが待機してたら嫌ですよね。おかしいですよね。そういうのはロボットが理解しなければいけない空間の「意味」なのだろうと思ったりするんです。

――建築では、図面などから空間の意味を読み解き、儀礼の場や団らんの場、移動の場、作業空間など場所の特性を明らかにすることを試みています。その点で、ロボットも同様に空間の意味を扱っているように感じました。

神田 そうですね。ロボットは今多くの空間のレパートリーを持っているわけではなくて、僕らもちょっとした研究程度にはしたことがあります。例えば買い物カートロボットです。「買い物の仕事が終わりました。ロボットはその後どこで待機すべきか」を計算させることは行ったことがあります。結局「邪魔にならない場所はどこか」という研究なんですよね。でもロボットだと相当センシング(レーザーなどで測定すること)するわけですよ。もしかしたら⼈をいっぱい⾒てると、ここはみんな⽌まってないなとかここ空いてるなとかわかるんです。けれども、今のお話からすると、人間は空間をパッと見ただけで(スキャンして)、「ここがどういう空間か」がわかるわけですよね。そこには「常識」や「暗黙知」がある。そうした人間の空間認識の仕方をロボットに応用できる可能性は、今のお話を聞いていると大いにありそうで、面白いなと思います。

――住宅内にロボットを置いた場合、どのように空間を認識するのかは非常に興味深いと思います。

神田 家の中に、ちょっと物を運んだり、持ったりできるロボットが、近い将来に出てくるのは不思議ではありませんね。そのロボットはどこで待っているのかといったら、そのロボットがどこで待機すべきか。まさに今のお話にあったように、玄関で待っていたら邪魔ですよね。人間なら「ここが待機場所だな」という定位置が、暗黙のうちにわかりそうな気がしますね。

参考文献

[1] Chao Shi, Masahiro Shiomi, Christian Smith, Takayuki Kanda, and Hiroshi Ishiguro, A model of distributional handing interaction for a mobile robot, Proceedings of Robotics: Science and Systems, pp.55-62, 2013.

[2] Drazen Brscic, Takayuki Kanda, Tetsushi Ikeda,Takahiro Miyashita, Person tracking in large public spaces using 3D range sensors, IEEE Transactions on Human-Machine Systems, Vol.43, Issue 6, pp.522-534, 2014.

神田 崇行(かんだ・たかゆき)

京都大学大学院情報学研究科教授 (2018-)・ATR 知能ロボティクス研究所客員研究室長。ヒューマンロボットインタラクションを専門とし、コミュニケーションロボット「ロボビー」の研究開発に従事。自律対話機構や社会的能力、人型ロボットの身体を活かした対話、日常生活場面での応用に強い関心を持ち、研究と社会実装を推進している。